Par Michel Negynas.

Le Premier ministre dispose d’un organisme de prospective, France stratégie .

La dernière étude de France Stratégie

France Stratégie définit ainsi ses missions :

« France Stratégie contribue à l’action publique par ses analyses et ses propositions. Elle anime le débat public et éclaire les choix collectifs sur les enjeux sociaux, économiques et environnementaux. Elle produit également des évaluations de politiques publiques à la demande du gouvernement. Les résultats de ses travaux s’adressent aux pouvoirs publics, à la société civile et aux citoyens. »

Elle succède au Commissariat général à la Stratégie et à la prospective, et elle est un lointain successeur au Commissariat général du Plan.

Beaucoup de ses analyses tombent dans un écologisme parfois quasi radical. Il est d’autant plus remarquable qu’en matière d’énergie, elle tranche avec le politiquement correct. Elle vient de publier une note d’analyse sur la sécurité de l’approvisionnement électrique en Europe à l’horizon 2030 .

Et ce n’est pas rassurant, surtout qu’en matière industrielle, 2030 c’est demain. Il y a donc peu de chances que la situation puisse être significativement améliorée d’ici là.

Quelques extraits

Dès les premières phrases :

« Dans la prochaine décennie, les nombreux arrêts de centrales pilotables, au charbon ou nucléaires, actuellement programmés et dont les conséquences concrètes semblent assez peu intégrées dans le débat public, pourraient renforcer l’importance de cette question. »

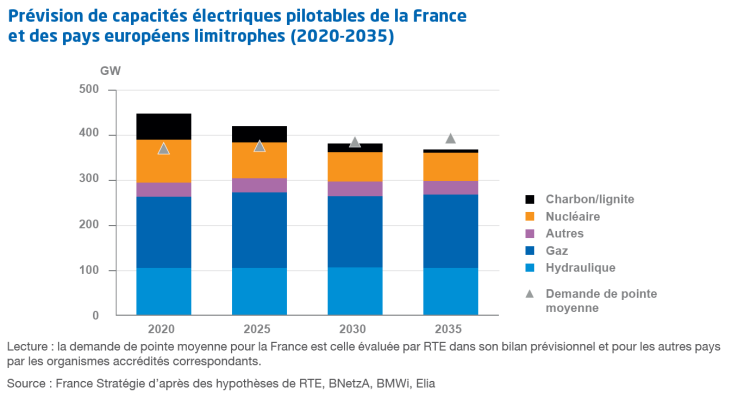

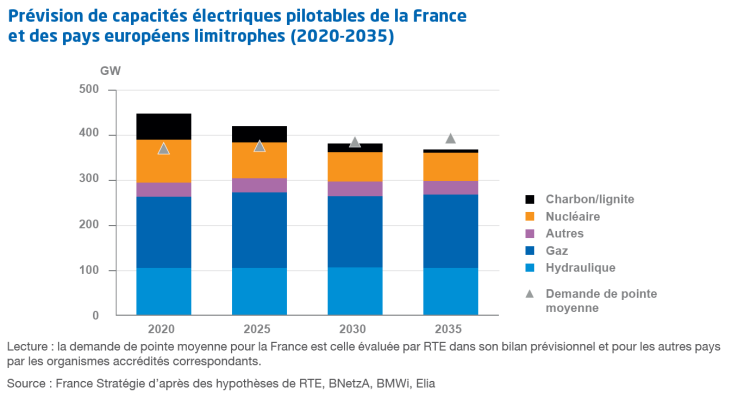

Et le diagramme introductif dit tout : au niveau européen, la demande en pointe est supposée rester constante à 400 GW ; de 50 GW de surcapacité en 2020 (à condition que tout fonctionne à 100 %,) on passe à 25GW de sous capacité en 2035. Ces chiffres sont en plus optimistes car les puissances par nature sont inégalement réparties géographiquement, comme par exemple l’hydraulique. Or, les distances et les capacités d’interconnexion ne permettent pas de faire n’importe quoi.

La première leçon est qu’il faut raisonner :

- au niveau européen, alors que chaque État décide de diminuer ses capacités en espérant se faire dépanner au besoin par les autres.

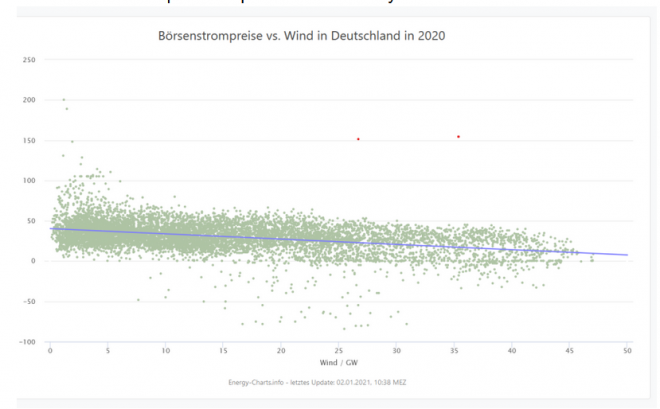

- en capacités pilotables, car les producteurs intermittents et aléatoires ne peuvent assurer une quelconque fourniture à la pointe d’hiver. Le soi-disant foisonnement du vent et du solaire sur toute l’Europe est une légende urbaine.

Mais France Stratégie enfonce le clou :

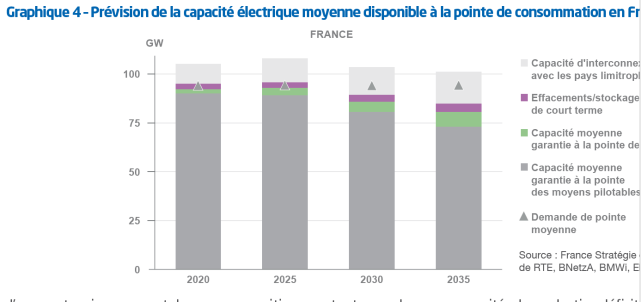

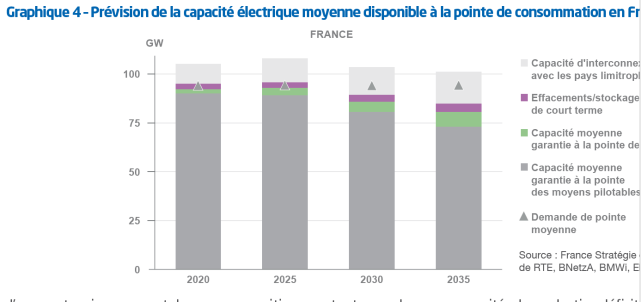

En France, on est déjà limite, même en raisonnant en capacité moyenne ; et la pénurie à 2035 est concentrée sur l’Allemagne, la Belgique et la France, c’est-à-dire le cœur du réseau européen.

RTE essaie de chiffrer les probabilités que l’on soit en situation tendue compte tenu des scenarii de la Programmation Pluriannuelle de l’Energie (PPE). Elles sont loin d’être nulles. On peut donc s’attendre à des périodes d’extrêmes fragilités du réseau. Elles donneront lieu à des coupures coordonnées si tout se passe bien. Mais tout incident, même mineur, peut provoquer le black out en cascade dans une telle situation. La gravité de cette éventualité est extrême. L’approche devrait donc être sécuritaire, et pas probabiliste.

Mais ce n’est pas tout.

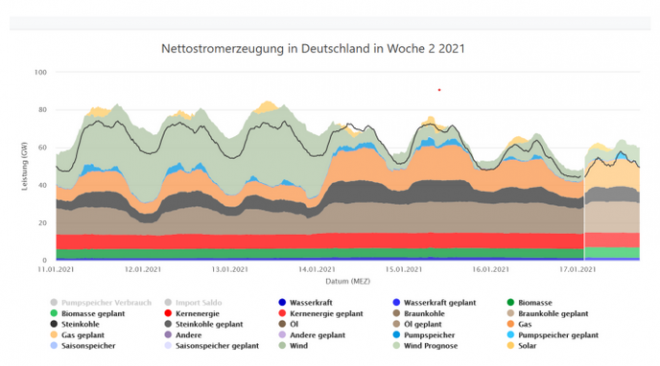

« Par ailleurs de fortes proportions d’ENRi complexifient le pilotage des réseaux, comme l’a montré la première période de confinement. L’apparition de congestions de plus en plus fréquentes sur les réseaux, en particulier de distribution, oblige les GRT (les centres de contrôle) à faire du « redispatching » et à déconnecter sélectivement un certain nombre d’installations (« écrêtement»). Ces opérations sont d’autant plus complexes que les ENR ont priorité d’injection sur le réseau, sont très réparties sur le territoire et peuvent connaître des variations de production très rapides. L’Observatoire Capgemini a rappelé dans son édition datée du 3 novembre 202029 que l’Allemagne et le Royaume-Uni ont subi pour ces raisons des quasi black-out respectivement les 21 avril et 23 mars 2020, en pleine crise de la Covid, les gestionnaires de réseau s’étant trouvés à court de moyens permettant de conserver l’équilibre du système. »

Comme cela a été maintes fois signalé sur Contrepoints , l’éolien et le solaire , en plus de ne guère contribuer à la production, fragilisent le réseau.

Sur le plan économique et ses conséquences sur l’investissement, France stratégie observe, comme tous les experts :

« L’arrivée de quantités massives d’ENRi, avec des coûts marginaux quasi nuls, sans tenir compte des conditions d’intégration au système électrique, a entraîné une chute des prix de marché de gros, de plus en plus souvent négatifs. Ce marché ne permet plus de déclencher les investissements nécessaires à la transition énergétique, ou simplement au maintien d’un accès fiable à l’électricité. »

Enfin, France stratégie met les pieds dans le plat :

« Le nouveau cadre européen de gouvernance (de l’énergie) tend à valoriser les investissements vertueux d’un point de vue environnemental, en particulier avec la taxonomie verte. Cependant, pour assurer l’atteinte de ses objectifs, il est essentiel d’assumer ses implications politiques. »

La taxinomie verte a fait l’objet d’un article ici .

Traduite en langage clair, si l’Europe veut vraiment poursuivre sa fuite en avant vers les énergies éoliennes et solaires, il faudra dire aux citoyens qu’ils devront baisser leur consommation et au besoin, admettre des coupures d’électricité.

En conclusion, parmi ses recommandations, France Stratégie ne peut que dire :

« Les énergies renouvelables matures posent des problèmes spécifiques d’intégration au réseau alors même qu’elles devraient voir à court terme leur part en puissance dépasser celle des centrales conventionnelles. Au risque de rendre non pilotable le système électrique, elles doivent donc le plus rapidement possible être en mesure de contribuer à son équilibre technique (participation à la réserve, au traitement des congestions réseaux […] Au niveau européen, on observe qu’en contradiction avec les objectifs climatiques et d’indépendance énergétique, plusieurs pays européens ont décidé de compenser les fermetures de centrales au charbon ou nucléaires par la mise en service de centrales à gaz, un moyen de production flexible et peu capitalistique. Cela se fait dans l’urgence pour certains (Belgique), de façon plus planifiée pour d’autres (Italie, Allemagne, Espagne) ou de manière prévisionnelle pour d’autres encore (pays de l’est de l’Europe). »

Il n’y a donc pas que sur Contrepoints qu’on peut lire ça.

Il est possible que les propos alarmistes distillés depuis quelques mois soient consécutifs à cette étude, et que nos gouvernants découvrent le problème. Mais ce n’est pourtant pas la première fois que France Stratégie tire la sonnette d’alarme.

Il y a des précédents

En août 2017, elle a publié une étude sur la transition énergétique allemande , qui est le modèle de notre transition puisque comme eux, nous voulons atteindre plus de 90 GW d’énergie intermittente (ils en sont en fait, maintenant, à 110 GW)

Une des conclusions est la suivante :

« La facture présentée au consommateur est très élevée pour la montée en puissance des ENR déjà accomplie, environ 25 milliards d’euros par an sur une durée de vingt ans. Les ENR qui se développent aujourd’hui sont encore soutenues financièrement et des coûts annexes imprévus, mal quantifiés mais très importants, apparaissent pour la construction de lignes et le maintien de la sécurité du réseau. Mais le plus inquiétant à court terme est peut-être la sécurité d’approvisionnement, car le réseau est aujourd’hui fragilisé par des flux massifs non contrôlables et intermittents d’électrons lorsque le solaire et l’éolien tournent à plein. »

C’était en 2017, peut-être faut-il du temps à un gouvernement pour réaliser… sauf que France Stratégie faisait déjà en 2014 les constatations suivantes dans une étude intitulée « La crise du système électrique européen ».

Cette étude s’attache plutôt aux conditions de marché, qui sont elles aussi surréalistes. Mais on y trouve :

« L’’intégration massive d’énergies renouvelables subventionnées et prioritaires sur le réseau conduit à une situation de surcapacité, déprime les prix de l’électricité sur le marché de gros (ils deviennent même parfois négatifs) et dégrade fortement la rentabilité des centrales thermiques à gaz : dans l’UE-27, près de 12 % des capacités thermiques fonctionnant au gaz pourraient fermer en l’espace de trois ans. Or ces centrales sont indispensables à l’équilibre du système qui doit faire face à l’afflux d’ENR intermittentes et aléatoires. Dans le même temps, d’importants investissements sont nécessaires au renouvellement des infrastructures vieillissantes. Plusieurs grands opérateurs, en graves difficultés financières – leur endettement net a doublé au cours des cinq dernières années –, auront du mal à y faire face .

C’est-à-dire qu’à cause des caractéristiques des ENR, ces programmes de transition sont tellement irréalistes qu’ils génèrent des conditions de marché qui éjectent les investissements nécessaires à la sécurisation du réseau ; en 2020, on en voit le résultat. On voyait déjà le problème dans les services du gouvernement en 2014.

Et si on veut chercher les avis des vrais experts, il faut aller en 2012. En vue de préparer la Loi sur la transition écologique, une commission a été mise sur pied . Elle était dirigée par messieurs Grandil et Percebois, experts mondialement reconnus en collaboration avec France Stratégie.

Elle a fait huit propositions dont la troisième :

« Ne pas se fixer aujourd’hui d’objectif de part du nucléaire à quelque horizon que ce soit, mais s’abstenir de compromettre l’avenir et pour cela maintenir une perspective de long terme pour cette industrie en poursuivant le développement de Gen-4. La prolongation de la durée de vie du parc actuel paraît donc la meilleure solution (sous la condition absolue que cela soit autorisé par l’ASN) »

En fait, la loi de Transition énergétique a pris l’exact contrepied des huit propositions !

Est-ce que ça va changer ?

Visiblement, les décideurs ont pris peur. Mais c’est juste pour 2023 ! Après ça ira mieux, on pourra arrêter 14 centrales nucléaires ! Pour l’instant, envers et contre tout, on en reste à la stratégie initiale décidée à des fins purement électorales. Contre l’avis de la Cour des comptes, de l’Académie des technologies, de France Stratégie…Un KW d’éolien et de solaire est toujours censé être équivalent à un KW gaz ou nucléaire !

Évidemment, d’autres organismes gouvernementaux sèment le trouble : l’ADEME s’aligne plus ou moins sur Greenpeace, et RTE reste dans l’ambiguïté.

RTE vient de publier, en liaison avec l’agence internationale de l’Energie, un rapport faussement intitulé dans la presse : 100 % d’électricité renouvelable c’est possible.

En réalité, les aspects économiques et sociaux ne sont pas abordés, et pour cause. Mais que dit le rapport ?

« Ce nouveau rapport, Conditions et prérequis en matière de faisabilité technique pour un système électrique avec une forte proportion d’énergies renouvelables à l’horizon 2050, met en avant quatre ensembles de conditions techniques strictes, qui devront être remplies pour permettre, avec une sécurité d’approvisionnement assurée, l’intégration d’une proportion très élevée d’énergies renouvelables variables dans un système électrique de grande échelle, comme celui de la France :

- Même si elles doivent encore faire l’objet d’une démonstration à grande échelle, il existe un consensus scientifique sur l’existence de solutions technologiques permettant de maintenir la stabilité du système électrique sans production conventionnelle. Des difficultés spécifiques pourraient concerner les systèmes comportant une part importante de photovoltaïque distribué pour lesquels il est nécessaire de poursuivre l’évaluation des impacts sur le réseau de distribution et la sûreté du système électrique.

- La sécurité d’alimentation en électricité (adéquation des ressources) — la capacité d’un système électrique à approvisionner la consommation en permanence — peut être garantie, même dans un système reposant en majorité sur des énergies à profil de production variable comme l’éolien et le photovoltaïque, si les sources de flexibilité sont développées de manière importante, notamment le pilotage de la demande, le stockage à grande échelle, les centrales de pointe, et avec des réseaux de transport d’interconnexion transfrontalière bien développés. La maturité, la disponibilité et le coût de ces flexibilités doivent être pris en compte dans les choix publics.

- Le dimensionnement des réserves opérationnelles et le cadre réglementaire définissant les responsabilités d’équilibrage et la constitution des réserves opérationnelles devront être sensiblement révisés, et les méthodes de prévision de la production renouvelable variable continuellement améliorées.

- Des efforts substantiels devront être consacrés au développement des réseaux d’électricité à compter de 2030, tant au niveau du transport que de la distribution. Cela nécessite une forte anticipation et un engagement public en matière de planification à long terme, d’évaluation des coûts et de concertation avec les citoyens pour favoriser l’acceptation des nouvelles infrastructures. Ces efforts peuvent néanmoins être partiellement intégrés au renouvellement des actifs de réseau vieillissants. »

Autrement dit, c’est presque possible, à condition de résoudre des impasses technologiques et économiques dont tous les experts disent qu’elles ne seront jamais opérationnelles, en tout cas pas à l’horizon 2050.

Avec des avis comme ça, on n’est pas prêts de changer de stratégie ! Sauf après un black out ?

chevron_right