-

chevron_right

chevron_right

Mathias Poujol-Rost ✅ · Sunday, 21 November, 2021 - 20:06

Contact publication

chevron_right

chevron_right

Mathias Poujol-Rost ✅ · Sunday, 21 November, 2021 - 20:06

Contact publication

Loi anti-Huawei : une balle dans le pied de notre 5G nationale

Yannick Chatelain · ancapism.marevalo.net / Contrepoints · Thursday, 11 February, 2021 - 04:00 · 6 minutes

Par Yannick Chatelain, Sylvain Colombero, Pierre Dal Zotto et Federico Pigni.

Les débats sont toujours passionnés autour du déploiement de la 5G , ses enjeux sont multiples et questionnent : possibles impacts sur la santé , sur la vie privée , etc. Nonobstant tous ses apports potentiels avérés :

C’est sur le terrain géopolitique que la 5G se retrouve en France sur l’avant-scène en brandissant une question de sécurité nationale.

Sans jamais être cité dans le texte constitutionnel, il a ainsi été décidé qu’Huawei – qui est techniquement parmi les leaders mondiaux sur la 5G – ne dominera pas le marché français de la 5G.

Dans le collimateur de nombreux pays dont les États-unis et l’Angleterre – les législateurs anglais affirment qu’existent « des preuves claires de collusion » entre Huawei et « l’appareil du Parti communiste chinois ». La France s’inscrit depuis plusieurs années dans le même mouvement de défiance.

Le Conseil constitutionnel a ainsi validé le vendredi 5 février les dispositifs figurant dans une loi du 1er août 2019, ciblant sans ambages le géant chinois des télécoms au grand dam des opérateurs télécoms français SFR et Bouygues Telecom, clients traditionnels de la firme. Ces derniers avaient déposé des questions prioritaires de constitutionnalité (QPC ) au regard des conséquences sur leur activité. Ils ont été déboutés.

Si la notion de sécurité nationale est invoquée, notons que les risques que représente Huawei sont les mêmes que pour n’importe quel acteur privé : celui qui contrôle une partie de l’infrastructure technologique au niveau du réseau peut accéder à des éléments critiques en lien avec les télécommunications, lesquels se doivent d’être protégés.

Ajoutons que de nombreux pays tendent à favoriser leurs propres acteurs économiques, et que le passé nous a appris que des usages dévoyés des technologies ne sont pas l’apanage de la Chine et n’ont pas attendu la 5G.

Pour la France cette loi ne sera pas sans conséquence. Il est difficile d’avancer qu’elle soutient nos opérateurs phares. Comme le soulignait la fédération française des télécoms :

Si demain, Huawei était amené à être interdit sur tout ou partie du territoire, il faut bien que chacun ait conscience des retards considérables que nous prendrions dans les déploiements. Ça serait un retard considérable pour les territoires, pour les entreprises françaises, pour la transformation numérique. Cela aurait un coût.

Dès 2019, une étude conduite en avril par la GSMA , l’association des opérateurs et constructeurs de téléphonie mobile, corroborait ce discours et alertait devant la montée en puissance d’une ostracisation fondée sur le soupçon.

Le journal Le Monde qui avait pu accéder à ce document non rendu public indiquait que :

Une exclusion des vendeurs chinois d’équipements télécoms du marché européen augmenterait la facture du déploiement de la 5G d’environ 55 milliards d’euros pour les opérateurs européens.

Dans les faits, et pour l’exemple sur notre territoire, le 28 août 2020 l’opérateur Bouygues Telecom anticipant une évolution défavorable avait annoncé le démantèlement de 3000 de ses antennes en France , soit un septième de ses équipements, d’ici 2028.

Si ce texte persiste à placer certains de nos opérateurs dans la difficulté et peut entraîner un ralentissement du déploiement physique de la 5G sur le territoire national, au sens technique de nombreux acteurs privés ou publics, européens (Thalès, Nokia, etc.) ou internationaux (KTSAT ou Huawei) notamment ont déjà investi dans la recherche et développement de la 5G.

Le développement technique étant aujourd’hui arrivé à maturité, l’enjeu se situe désormais au niveau du développement commercial de la 5G. C’est ce dernier qui risque d’être altéré ; le seul frein proviendrait donc des marchés verticaux qui ne voudraient ou ne pourraient pas innover en n’intégrant pas la 5G dans leur business models.

Les potentiels leviers de croissance sont énormes, et cela pour différents secteurs : urbanisme avec les smarts cities , automobile avec la voiture autonome, industrie avec les jumeaux numériques… Avec les retards connus sur la mise aux enchères des fréquences, si la France devait persister dans une défiance outrancière, elle risquerait de cumuler du retard sur le déploiement de la 5G alors même que les recherches sur la 6G ont déjà débuté sur le territoire.

À qui sait attendre, le temps ouvre ses portes – Proverbe chinois

Pour conclure, cette loi, qui ne peut être qualifiée de Huawei- friendly , ne semble pas avoir à ce jour altéré la sérénité de cette dernière. Nulle marche arrière n’a été évoquée quant à l’installation de sa première usine hors de Chine à Brumath, près de Strasbourg.

Cette usine devrait ouvrir en 2023, le géant chinois y produira du matériel pour les réseaux mobiles, notamment 5G. 500 emplois seront créés, et sa vocation sera de desservir toute l’Europe.

Si la firme ne s’est pas rétractée, le porte-parole de l’ambassade de Chine a toutefois laisser entendre le 9 février que :

Si l’équipementier chinois devait faire l’objet de discriminations ou d’une interdiction dans l’Hexagone, Pékin pourrait, en retour, prendre des mesures de rétorsion à l’égard de Nokia et d’Ericsson dans l’Empire du Milieu…

Dans un monde qui se prépare à une crise économique historique, la France se montrera-t-elle demain plus sensible à la diplomatie du carnet de chèques ?

À suivre…

Federico Pigni est Senior Professeur au département Management et Technologie. Dean (GEM).

Sylvain Colombero est Professeur Assistant au département Management et Technologie (GEM)

Pierre Dal Zotto est Professeur Assistant Coordinateur de la Chaire Digital, Organization & Society (GEM)

Yannick Chatelain est Professeur Associé au département Marketing, responsable « GemInsights » (GEM)

Neutralité du Net : l’Europe doit-elle déréguler en réponse aux États-Unis ?

The Conversation · ancapism.marevalo.net / Contrepoints · Tuesday, 26 January, 2021 - 03:30 · 6 minutes

Par et 1

Un article de The Conversation

La neutralité du Net est le principe selon lequel les flux de données qui circulent dans les réseaux ne doivent faire l’objet d’aucune différentiation de la part des intermédiaires qu’ils traversent, notamment les opérateurs télécoms comme Orange ou Free. Ce principe est protégé par la loi en Europe depuis 2015.

Il est ainsi interdit à un opérateur de ralentir certains flux par rapport à d’autres ; de même, un opérateur ne peut pas créer de « tarif premium » qui proposerait à un fournisseur de service (de streaming video, par exemple) un meilleur traitement dans le réseau et donc un avantage sur d’autres services comparables.

Parmi les justifications de ce principe, on trouve une volonté d’assurer une certaine équité entre les acteurs économiques qui utilisent Internet, et de permettre à de nouveaux services d’apparaître sans la barrière à l’entrée que constituerait un tarif premium. Des start-up, avec peu de moyens mais des idées innovantes, pourraient ainsi être directement compétitives face aux acteurs établis. Mais que se passe-t-il si la régulation en termes de neutralité du Net diffère d’un pays à l’autre ?

L’innovation est-elle toujours protégée dans les régions qui imposent la neutralité du Net ? La question se pose notamment depuis que la neutralité n’est plus protégée aux États-Unis, une décision effective depuis le 11 juin 2018 . On a alors constaté aux États-Unis que certains opérateurs ralentissaient des services spécifiques gourmands en ressources comme YouTube ou Netflix , de manière perceptible : un débit observé limité à seulement 10 % du débit possible pour certains opérateurs.

Les mesures sont réalisées par des outils comme Wehe , utilisé également par le régulateur français des télécoms (ARCEP) pour surveiller les opérateurs. Produire de telles réductions peut avoir un intérêt pour les opérateurs, la proportion de bande passante utilisée par les grands acteurs étant non négligeable : en France, 55 % du trafic vers les clients des principaux fournisseurs d’accès provient de quatre fournisseurs uniquement – Netflix, Google, Akamai et Facebook .

La différentiation aux États-Unis n’est pas encore sur un modèle avec « voie rapide » payante, mais les défenseurs de la neutralité arguent que les changements se feront de manière lente et graduelle afin de ne pas provoquer de rejet massif des utilisateurs et associations.

À quoi s’attendre donc, si une partie de l’internet adopte un système avec voie rapide payante (non-neutre) alors que l’autre interdit ce type de discrimination ? Les États-Unis risquent-ils de pénaliser l’innovation avec leur décision de libéraliser les réseaux ? Ou au contraire, favorisent-ils leurs acteurs économiques en compétition avec ceux du reste du monde ?

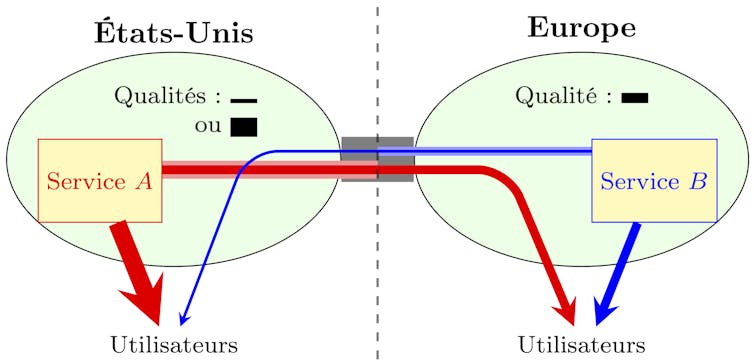

Sans prétendre résoudre cette question, mais seulement pour illustrer quels phénomènes sont susceptibles de survenir, considérons le scénario de la figure 1, avec deux zones : dans l’une (la neutre) une seule qualité de service est disponible, alors que le trafic peut être traité avec deux qualités différentes dans l’autre zone, la meilleure étant accessible moyennant paiement.

Qualités disponibles dans une zone neutre et une zone non neutre, représentées par l’épaisseur des lignes. Les qualités perçues par les utilisateurs de chaque zone sont représentées pour le cas où A choisit la meilleure qualité dans la zone non neutre alors que B y est traité avec la plus faible qualité. Author provided (No reuse)

Qualités disponibles dans une zone neutre et une zone non neutre, représentées par l’épaisseur des lignes. Les qualités perçues par les utilisateurs de chaque zone sont représentées pour le cas où A choisit la meilleure qualité dans la zone non neutre alors que B y est traité avec la plus faible qualité. Author provided (No reuse) Pour simplifier, on suppose qu’il n’y a qu’un opérateur dans chaque zone. Considérons alors deux fournisseurs de service A et B (par exemple, des plates-formes de streaming vidéo) comparables, hébergés dans la zone non neutre et neutre, respectivement. Pour atteindre les utilisateurs situés dans la zone éloignée, les flux doivent alors traverser les deux zones. Dans ce cas, comme qualité perçue par l’utilisateur final on prendra la moins bonne qualité rencontrée par le flux, c’est-à-dire la qualité du goulot d’étranglement.

Dès lors, des questions clé concernant la coexistence de ces deux zones à réglementation différente apparaissent :

Si dans un premier temps, la neutralité en Europe interdit aux services hébergés en Europe de payer pour la voie rapide aux États-Unis, alors il semble que les entreprises américaines soient favorisées : dans le scénario de la figure 1, les utilisateurs en Europe perçoivent les deux services avec la même qualité, alors que le service américain a un très net avantage en qualité pour les utilisateurs aux États-Unis.

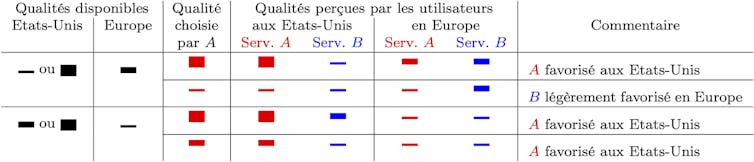

Les autres cas possibles, selon la qualité choisie par le service A hébergé aux États-Unis et les qualités disponibles dans les deux zones, sont illustrés en table 1. On remarque que même si A choisit la qualité la plus faible, il n’est que légèrement moins bien servi en Europe que son concurrent européen lorsque la qualité « neutre » est meilleure que la voie lente aux États-Unis.

Et si les prédictions optimistes concernant la dérégulation aux États-Unis se vérifient, à savoir, que les deux qualités en zone dérégulée soient meilleures que dans la zone régulée (argument de l’incitation pour les opérateurs à investir dans le réseau car ils seront autorisés à en optimiser les dividendes), alors dans tous les cas les services hébergés en zone non neutre sont favorisés.

Qualités perçues pour chaque service par les utilisateurs selon leur zone géographique, pour différents scénarios (qualités disponibles et choix de la qualité par A, un scénario par ligne). En choisissant la voie rapide, le service hébergé aux États-Unis a toujours un avantage sur celui hébergé en Europe. (Le cas où les deux qualités aux États-Unis seraient inférieures à la qualité de la zone neutre ne semblant pas réaliste, il n’est pas présenté.) Author provided

Qualités perçues pour chaque service par les utilisateurs selon leur zone géographique, pour différents scénarios (qualités disponibles et choix de la qualité par A, un scénario par ligne). En choisissant la voie rapide, le service hébergé aux États-Unis a toujours un avantage sur celui hébergé en Europe. (Le cas où les deux qualités aux États-Unis seraient inférieures à la qualité de la zone neutre ne semblant pas réaliste, il n’est pas présenté.) Author provided Ces exemples simples montrent que les décisions régulatoires des États-Unis concernant la neutralité du Net sont susceptibles d’affecter les acteurs économiques de tout l’internet. La réponse du régulateur européen risque donc d’impliquer un arbitrage entre les principes qui justifient la neutralité, et les intérêts des entreprises et des utilisateurs européens.

This article is republished from The Conversation under a Creative Commons license. Read the original article .

![]()

Les éléments du progrès : le silicium (4)

HumanProgress · ancapism.marevalo.net / Contrepoints · Sunday, 24 January, 2021 - 04:25 · 7 minutes

Par Tony Morley.

Un article de HumanProgress

Le silicium est un élément métallique brillant et semi-conducteur utilisé pour la fabrication de l’acier, de l’aluminium, des cellules solaires photovoltaïques et, bien sûr, des puces de processeur d’ordinateur.

Après l’oxygène, le silicium est l’élément le plus abondant contenu dans la croûte terrestre, représentant près de 30 % de sa masse. Cependant, à l’état de corps simple il ne se trouve pas sous forme pure dans la nature. Il est généralement lié à l’oxygène sous forme minérale.

On trouve ce type de silicium en abondance sous forme de dioxyde de silicium (SiO2), de quartzite, de quartz, de sable de plage ordinaire et de centaines d’autres composés minéraux.

C’est le chimiste suédois Jöns Jacob Berzelius qui a été le premier à isoler et à décrire le silicium élémentaire en 1824. Cependant, la capacité d’isoler et de fabriquer en masse du silicium métallique de haute pureté ne sera atteinte que beaucoup plus tard.

Depuis près de cinq mille ans, l’homme transforme en verre le dioxyde de silicium présent dans le sable , améliorant constamment sa capacité à le faire. La production de verre à base de silicium a transformé notre capacité collective à créer de l’art, de la verrerie, et plus tard à développer l’optique qui allait contribuer à fonder les idées de la révolution scientifique, vers 1540 à 1650.

L’utilisation du verre dans les premiers instruments scientifiques a révolutionné la compréhension scientifique, contribuant à des découvertes majeures en physique, astronomie, chimie et biologie. Cette révolution s’est poursuivie avec l’avènement du soufflage de verre amélioré et la gamme plus étendue d’instruments plus perfectionnés qu’il permettait.

L’essor de la révolution industrielle, l’amélioration de la technologie du verre déployée dans les microscopes, les télescopes, les thermomètres et une pléthore innombrable d’instruments de laboratoire, a transformé notre compréhension du monde naturel.

Le verre continue à rendre un service inestimable au développement de la société industrialisée, qu’il s’agisse du verre haute résistance et résistant aux rayures que l’on trouve dans des milliards de téléphones portables et d’écrans d’ordinateurs, du verre de protection utilisé pour les fenêtres de nos maisons, bureaux et véhicules ou du verre plus courant utilisé dans un million d’autres applications.

L’humanité produit environ 6,7 millions de tonnes de silicium par an. Environ 80 % sont produits sous forme de ferrosilicium utilisé dans la fabrication du fer et des aciers à haute performance aux propriétés de résistance aux températures élevées et à la corrosion, ou utilisés dans l’alliage avec l’aluminium. L’alliage de l’aluminium avec le silicium améliore sa solidité et sa résistance à la corrosion, tout en améliorant les performances de moulage du métal ; il est couramment utilisé dans le moulage et la production de moteurs.

Une très petite proportion du dioxyde de silicium de haute pureté extrait chaque année – environ 15 % – est destinée à devenir la matière première des plaquettes qui constituent les unités centrales de traitement des milliards de téléphones portables et de systèmes informatiques.

Le premier transistor au silicium fonctionnel a été développé en 1954 aux Bell Labs par un physico-chimiste américain, Morris Tanenbaum. Le transistor a été plutôt mal accueilli à l’époque, et peu de gens auraient pu spéculer avec précision sur la façon dont les transistors au silicium allaient transformer radicalement le progrès et la croissance de la société.

Le silicium polycristallin de qualité processeur (une forme hautement purifiée de silicium métallique) est le matériau de base des plaquettes sur lesquelles sont construites les unités centrales de traitement.

Cependant, il est courant mais faux de penser que le silicium des puces informatiques est fabriqué à partir du sable d’une plage quelconque. S’il est vrai que les puces de silicium sont fabriquées à partir de sable, il ne s’agit en aucun cas de sable ordinaire.

Le dioxyde de silicium sous forme de sable remplit nos plages, couvre le fond des deltas des rivières et des océans, et recouvre nos déserts. Cependant, tout le sable d’Arabie saoudite ne fournira pas à la civilisation le silicium nécessaire à un seul microprocesseur. Pour atteindre les niveaux étonnamment élevés de pureté du silicium requis, le matériau source doit lui-même être d’une pureté inégalée.

Ces sources de dioxyde de silicium ultra-pur sont exploitées dans quelques endroits seulement dans le monde, peut-être plus particulièrement dans un ensemble de petites mines à Spruce Pine, Tennessee. Les mines à ciel ouvert de dioxyde de silicium blanc de haute pureté sont si brillantes qu’elles brillent comme un phare lorsqu’on les regarde depuis Google Earth.

Une fois exploitée, la roche mère de dioxyde de silicium doit être lavée, broyée, filtrée pour éliminer les impuretés, conditionnée et préparée pour la fusion. Le silicium élémentaire pur doit être libéré des liaisons d’oxygène par une fusion à très haute température dans un puissant four à arc électrique.

Le dioxyde de silicium est mélangé à deux sources principales de carbone, généralement le charbon et le bois, et placé dans le four, où le carbone ajouté aide à évacuer l’oxygène sous forme de dioxyde de carbone gazeux. On obtient ainsi du silicium élémentaire pur à 99 %.

Malheureusement, du point de vue du processeur informatique, une pureté de 99 % ressemble à un désert. Ce qu’il faut, c’est un lingot d’une pureté de 99,9999999999999 %. Cela représente un atome de non-silicium pour sept milliards d’atomes de silicium. Cela équivaut à une personne sur l’ensemble de la population humaine.

Pour atteindre ce niveau de pureté étonnant, le silicium métallique est soumis à une série de processus chimiques. Ces processus convertissent le silicium métallique en tétrachlorure de silicium – un composé nécessaire à la production de verre de fibre optique à haute performance qui transporte 99 % des données de communication intercontinentale du monde par quelque 285 câbles de données sous-marins.

Le produit secondaire, le trichlorosilane, est ensuite transformé en polysilicium, le silicium ultra-pur qui sera transformé en plaquettes informatiques en silicium. De là, le polysilicium est fondu à haute température et sous atmosphère de gaz inerte, dans un creuset en quartz pur.

Le creuset en fusion est maintenu en rotation et un cristal germe de silicium ultra-pur est inséré, sur lequel le silicium fondu dans le creuset commence à croître. Au fur et à mesure de sa croissance, le cristal est soigneusement tiré – vers le haut et vers l’extérieur – de la masse fondue dans un mouvement continu extrêmement lent. Une fois terminé, un monocristal de silicium pur a été cultivé, avec une masse d’environ 100 kg, soit 220 livres.

Les lingots sont découpés avec précision et polis pour obtenir une finition miroir sans défaut. Les plus parfaits de ces disques circulaires de silicium pur sont le support sur lequel est gravée l’architecture des processeurs informatiques des unités centrales modernes. D’autres plaquettes sont transformées en matériau de base des cellules solaires.

La qualité, la pureté et les propriétés physiques des plaquettes de silicium finies n’ont pas changé de façon spectaculaire au cours de la dernière décennie. Cependant, l’architecture des microprocesseurs gravés sur ce silicium s’est beaucoup améliorée. Le silicium est un exemple parfait de ressource matérielle ayant peu de valeur intrinsèque, jusqu’à ce que l’homme lui confère la capacité d’effectuer un travail utile.

Au cours des prochaines décennies, le silicium continuera à constituer la base de notre ère numérique. Le silicium témoigne de la capacité de la civilisation à transformer une ressource minérale apparemment sans valeur en l’un des produits les plus avancés technologiquement et les plus précieux que l’humanité ait créés.

—

L’agriculture cellulaire, c’est l’avenir… sauf en France ?

Constance Peruchot · ancapism.marevalo.net / Contrepoints · Monday, 28 December, 2020 - 04:20 · 6 minutes

Un entretien avec la directrice de l’association Agriculture Cellulaire France, Nathalie Rolland, réalisé par Constance Péruchot pour Contrepoints.

Dans un essai datant de 1931, Winston Churchill parlait de la nécessité d’échapper à l’absurdité de devoir élever un poulet entier, pour produire uniquement la partie qui sera mangée. Déjà, la classe politique s’intéressait à notre assiette et son futur.

Depuis quelques années, l’élucubration de Churchill ne semble plus si fantaisiste. En 2013, les futurs fondateurs de Mosa Meat présentaient au monde le premier steak haché cultivé en laboratoire. La méthode consiste, dans les grandes lignes, à prélever un petit échantillon de tissu musculaire sur un animal pour isoler une cellule musculaire et la faire développer dans un milieu adapté afin d’obtenir des fibres musculaires et enfin, du tissu musculaire qui sera la base de la viande cultivée.

Une première mondiale suivie par de nombreuses innovations issue de l’agriculture cellulaire : poulet (Super Meat, Future Meat Technologies), lait (Perfect Day), blanc d’œuf (Clara Foods), porc (New Age Meats, Higher Steaks, Meatable). Aujourd’hui, la recherche et développement arrivent à un point de maîtrise qui rapproche de plus en plus ces produits de nos rayons de supermarché.

Début décembre, Singapour a été le premier État à autoriser la mise sur le marché des produits Eat Just Inc., issus de l’agriculture cellulaire. Pour les entreprises du secteur, il s’agit du premier pas vers un développement massif de l’échelle de production. Progrès sanitaire, éthique et potentiellement environnemental, l’agriculture cellulaire suscite de vives réactions de la part de certaines personnalités politiques, dont le ministre français de l’Agriculture et de l’Alimentation.

Dans un tweet , Julien Denormandie a déclaré sa défiance envers la technologie de l’agriculture cellulaire, en concluant « Comptez sur moi pour qu’en France, la viande reste naturelle et jamais artificielle ! »

Nous avons souhaité interroger la directrice de l’association Agriculture Cellulaire France, Nathalie Rolland, à propos de cette réaction ainsi que des perspectives du secteur en France. Créée en 2019, Agriculture Cellulaire France a pour mission d’informer, alimenter la réflexion autour de l’agriculture cellulaire et encourager la recherche. L’un des défis principaux de l’association est d’accompagner les décideurs publics dans leur connaissance du secteur.

C : Nathalie, quel pourrait être l’impact de la prise de position de Julien Denormandie pour le marché de l’agriculture cellulaire en France ?

Nathalie Rolland : Le tweet de M. Denormandie est une réaction personnelle aux événements récents d’autorisation de commercialisation de la viande cultivée à Singapour, qui n’engage la France ni dans le présent ni dans l’avenir.

L’autorisation d’un nouvel aliment est une décision prise au niveau européen. Des individus, décideurs et organisations souhaitent que le domaine de l’agriculture cellulaire se développe en France. Il nous semble important que les consommateurs qui souhaitent se tourner vers les produits de l’agriculture cellulaire puissent le faire.

Le danger est que les Français se retrouvent à consommer des produits fabriqués ailleurs et que la France rate cette opportunité de compétitivité qu’offre le développement des protéines alternatives, domaine sur lequel notre pays a toutes les capacités de se positionner en leader.

C : Dans certains pays, l’agriculture cellulaire est en effet soutenue par les gouvernements. En Israël, Benyamin Netanyahu a visité il y a quelques jours les laboratoires de l’entreprise Aleph Farms, qui développe des steaks cultivés. C’est avec enthousiasme et même émotion que le Premier ministre a exprimé son soutien à cette innovation qui « change la réalité humaine » , selon ses termes.

Qu’attend l’association Agriculture Cellulaire France du gouvernement français?

Nathalie Rolland : Nous pensons que le gouvernement français doit soutenir le développement de ce domaine afin d’aider à résoudre les problèmes posés par l’élevage industriel. Ces produits sont développés pour être meilleurs pour l’environnement, la santé et le bien-être des animaux. Ils devraient produire moins de gaz à effet de serre si des énergies propres sont utilisées, demander beaucoup moins de terres et d’eau, moins polluer l’eau, lutter contre la déforestation et ainsi préserver les habitats naturels.

En plus de demander moins de ressources naturelles, ces produits aideront à lutter contre l’antibiorésistance et la propagation de maladies zoonotiques.

Enfin, aucun animal ne devra être tué dans le développement de ces produits. C’est pourquoi d’autres gouvernements soutiennent leur développement, comme par exemple le gouvernement flamand qui a octroyé une subvention de 3,6 millions d’euros à la recherche sur le développement de cellules de graisse. Plusieurs projets ont également reçu des soutiens financiers de l’Union européenne (ex : Meat4All, CCMeat, Cultured Beef, etc.).

C : Où en est la recherche au niveau mondial dans le domaine de l’AC ?

Nathalie Rolland : Il y a de plus en plus de projets de recherche financés par des gouvernements et des ONG. Nous pouvons donc dire que la recherche avance. En Allemagne, l’université technique de Munich est en train de mettre en place une chaire sur l’agriculture cellulaire.

Cependant, la recherche sur ce sujet est encore sous-développée, ainsi que ses financements. Côté français, nous ne connaissons aucun projet de recherche publique sur le sujet et nous déplorons cette situation. Il ne faudrait pas que la France prenne trop de retard sur le sujet.

C : Les réticences politiques à l’égard de l’agriculture cellulaire sont en partie liées à ses conséquences sur la filière viande en France et ses éleveurs. Vers quel modèle se dirige-t-on ?

Nathalie Rolland : Il est difficile d’estimer les transformations du marché de la viande en raison de l’agriculture cellulaire. Le développement de l’agriculture cellulaire pourrait évoluer vers un petit marché de niche avec peu d’implications pour le marché de la viande. Ce domaine pourrait aussi représenter une partie significative de ce marché dans quelques années comme le suggèrent certaines études ( 35 % du marché en 2040 ).

Nous pensons que ces produits mettront encore du temps à arriver sur le marché. Ce que nous espérons est que l’agriculture cellulaire remplacera une partie significative de la production industrielle de produits animaux pour que se réalisent ses bénéfices potentiels sur l’environnement, notre santé et les animaux.

L’élevage conventionnel continuera à exister, et nous espérons que les éleveurs pourront retourner à un élevage plus traditionnel et qualitatif. Certains chercheurs estiment que l’agriculture cellulaire peut être compatible avec le maintien d’une production locale, et offrir des opportunités aux éleveurs.

Il est par exemple possible d’envisager un scénario dans lequel des animaux (à la campagne ou dans des fermes urbaines respectueuses des animaux) serviraient de donneurs vivants de cellules souches pour la production de la viande.

De manière générale, on peut s’attendre à ce que les éleveurs continuent d’adresser la demande des consommateurs privilégiant les produits animaux conventionnels et que l’agriculture cellulaire aidera à répondre à une très forte demande mondiale en produits animaux.

—

Retrouvez toutes les informations sur l’association Agriculture Cellulaire France sur leur site : https://agriculturecellulaire.fr/

Charles Babbage et Ada Lovelace, précurseurs de l’informatique – Les Héros du progrès (49)

Alexander Hammond · ancapism.marevalo.net / Contrepoints · Sunday, 27 December, 2020 - 04:25 · 10 minutes

Par Alexander C. R. Hammond.

Un article de HumanProgress

Voici le quarante-neuvième épisode d’une série d’articles intitulée « Les Héros du progrès ». Cette rubrique est une courte présentation des héros qui ont apporté une contribution extraordinaire au bien-être de l’humanité.

Nos héros de la semaine sont Charles Babbage et Ada Lovelace, deux mathématiciens anglais du XIXe siècle à l’origine de l’informatique.

On qualifie souvent Babbage de « père de l’informatique » pour avoir conçu le premier calculateur numérique automatique.

S’appuyant sur son œuvre, Ada Lovelace a été la première à envisager que les calculateurs puissent avoir des applications pratiques, au-delà des seuls calculs. Elle a été gratifiée du titre de « premier programmeur » de par sa création du premier algorithme pour la machine de Babbage.

Leurs travaux ont jeté les bases des ordinateurs contemporains. Il est probable que sans leurs contributions une grande part de la technologie dont nous disposons actuellement n’existerait pas.

Charles Babbage est né le 26 décembre 1791 à Londres. Son père est un banquier prospère et il grandit dans l’opulence. Enfant, il fréquente plusieurs des meilleures écoles privées d’Angleterre. Son père s’assure qu’il dispose de nombreux tuteurs pour l’assister dans son éducation.

Adolescent, il rejoint la Holmwood Academy dans le Middlesex dont la vaste bibliothèque l’aide à développer une passion pour les mathématiques. En 1810, il en commence l’étude à l’université de Cambridge.

Avant son arrivée à Cambridge, il a déjà appris beaucoup des mathématiques contemporaines et est très déçu du niveau de leur enseignement à l’université.

En 1812, il crée avec un groupe d’amis la « Société Analytique » destinée à présenter en Angleterre des nouveaux développements en mathématiques apparus ailleurs en Europe. Sa réputation de génie des maths s’étend rapidement.

Vers 1815, il quitte Cambridge et donne des cours d’astronomie à la Royal Institution .

L’année suivante, il est élu membre de la Royal Society . Malgré plusieurs conférences appréciées à la Royal Institution , il a du mal à trouver un emploi à temps plein dans une université. De ce fait, au début de sa vie d’adulte, il doit compter sur le soutien financier de son père.

En 1820, il participe à la création de la Royal Astronomical Society , dont l’objet est de standardiser les calculs astronomiques.

Au début du XIXe siècle, les tables mathématiques (les résultats de calculs sous la forme de listes de nombres) sont cruciales pour l’ingénierie, l’astronomie, la navigation et la science. Cependant, à cette époque, tous les calculs de ces tables sont effectués par des humains et les erreurs sont courantes.

Considérant ce problème, Charles Babbage se demande s’il ne pourrait pas créer une machine servant à mécaniser le calcul.

En 1822, dans un document adressé à la Royal Astronomical Society , il précise son idée de création d’une machine à même de calculer automatiquement les valeurs des tables astronomiques et mathématiques.

L’année suivante, il parvient à obtenir une subvention de l’État pour construire une machine qui calculerait automatiquement une série de valeurs jusqu’à vingt décimales, surnommée la « machine à différences ».

En 1828, il devient professeur lucasien de mathématiques à l’université de Cambridge. Il est très désinvolte quant à ses tâches d’enseignement et passe le plus clair de son temps à écrire des articles et à travailler sur sa machine.

En 1832, avec son ingénieur Joseph Clement, ils en produisent une maquette fonctionnelle.

L’année suivante, les plans pour construire une machine plus grande, à l’échelle, sont mis au panier lorsqu’il commence à s’intéresser à un autre projet. Au milieu des années 1830, il attaque le développement des plans de ce qu’il nomme la « machine analytique » et qui allait devenir le précurseur de nos ordinateurs modernes.

Là où la machine à différences est conçue pour de l’arithmétique mécanique (essentiellement un calculateur primitif seulement capable de faire des additions), la machine analytique doit pouvoir exécuter n’importe quelle opération en lui soumettant des instructions via des cartes perforées, un bout de papier cartonné pouvant contenir des données selon la présence ou l’absence de trous à des endroits prédéterminés. Les cartes perforées pourraient aussi bien fournir des instructions au calculateur mécanique que recueillir les résultats des calculs effectués par la machine.

Tout comme pour les ordinateurs d’aujourd’hui, dans son principe, la machine analytique sépare les programmes des données.

L’unité de contrôle peut faire des sauts conditionnels, séparer entrées et sorties et son fonctionnement général est basé sur un jeu d’instructions.

Au départ, Charles Babbage ne voit la machine analytique que comme un instrument dédié au calcul et rien d’autre. Il en sera bientôt autrement grâce aux travaux d’Ada Lovelace.

Augusta Ada King, Comtesse de Lovelace, nait Byron le 10 décembre 1815 à Londres.

Elle est le seul enfant légitime du poète et député Lord Byron et de la mathématicienne Anne Isabella Byron. Mais à peine un mois après sa naissance, Byron se sépare de sa mère et quitte l’Angleterre.

Huit ans plus tard, une maladie l’emporte alors qu’il se bat aux côtés des Grecs dans leur guerre d’indépendance.

Au début de sa vie, Ada Lovelace est élevée par sa mère selon un régime strict de sciences, logique et mathématiques. Bien que fréquemment malade et alitée pendant presque une année quand elle a 14 ans, elle est fascinée par les machines.

Enfant, elle conçoit souvent bateaux et engins volants imaginaires. À l’adolescence, elle affute ses capacités en mathématiques et fait rapidement la connaissance de nombreux intellectuels en vue.

En 1833, sa tutrice Mary Somerville la présente à Charles Babbage. Ils deviennent vite amis.

Ada est fascinée par les plans de la machine analytique et Charles Babbage si impressionné par ses possibilités en mathématiques qu’il la décrit comme « l’enchanteresse des nombres ».

En 1840, il se rend à l’université de Turin pour y animer un colloque sur sa machine analytique. Y assiste également Luigi Menabrea, un ingénieur italien et futur Premier ministre du pays, qui le traduit en français. Ada Lovelace passera neuf mois de l’année 1842 à traduire en anglais l’article de Menabrea.

Elle y ajoute ses propres notes détaillées et se retrouve avec un texte trois fois plus long que l’original.

Il est publié en 1843 et décrit les différences entre la machine analytique et les précédentes machines à calculer, principalement sa capacité à être programmée pour résoudre n’importe quel problème mathématique.

Ses notes comprennent aussi un nouvel algorithme pour calculer une séquence de nombres de Bernoulli (une suite de nombres rationnels couramment rencontrés en théorie des nombres).

Comme son algorithme est le premier créé pour être spécifiquement utilisé sur un calculateur, elle devient le premier programmeur informatique au monde.

Alors que Charles Babbage a conçu la machine analytique dans une optique purement mathématicienne, Ada Lovelace est la première personne à percevoir le potentiel des ordinateurs, bien au-delà des simples calculs.

Elle réalise qu’on peut utiliser les nombres contenus dans la machine pour représenter d’autres entités comme des lettres ou des notes de musique.

Elle a donc aussi entrevu beaucoup des concepts associés aujourd’hui aux ordinateurs, notamment les logiciels et les sous-programmes.

La machine analytique n’a jamais été réellement construite de leur vivant. Cependant, l’absence de fabrication relève davantage de problèmes de financement et de conflits de personnalité entre Babbage et des donateurs potentiels que de défauts de conception.

Pendant le restant de sa vie, Babbage touche un peu à tout. Il tente plusieurs fois de se faire élire député. Il écrit plusieurs livres dont un sur l’économie politique dans lequel il étudie les avantages commerciaux de la division du travail.

Il joue un rôle essentiel dans la mise en place du système postal anglais.

Il a aussi inventé un des premiers types d’indicateurs de vitesse et les pare-buffles des locomotives (la grille métallique fixée à l’avant des trains pour dégager la voie des obstacles).

Le 18 octobre 1871, il meurt à son domicile londonien à l’âge de 79 ans.

Après sa traduction de la conférence de Babbage, Ada Lovelace se lance sur divers projets dont la création d’un modèle mathématique sur la façon dont le cerveau crée des pensées et sur le système nerveux, projet qui n’aboutira pas.

Le 27 novembre 1852, elle meurt d’un cancer de l’utérus à 36 ans à peine.

Au cours de sa vie, Charles Babbage a refusé les titres de chevalier et de baronnet. En 1824, il reçoit la médaille d’or de la Royal Astronomical Society « pour son invention d’un mécanisme de calcul des tables mathématiques et astronomiques ».

Depuis la mort de Charles Babbage et Ada Lovelace, de nombreux bâtiments, écoles, départements universitaires et récompenses ont été baptisés en leur honneur.

Grâce à leurs travaux le domaine du calcul a été changé à jamais. Sans l’œuvre de Charles Babbage, le premier ordinateur n’aurait pas été conçu. De même, beaucoup des principaux éléments de nos ordinateurs n’auraient probablement été développés que bien plus tard.

Sans Ada Lovelace, il aurait pu falloir beaucoup plus de temps à l’humanité pour réaliser que les ordinateurs peuvent effectuer bien plus de tâches que simplement des calculs mathématiques.

Ensemble, Charles Babbage et Ada Lovelace ont jeté les bases de l’informatique moderne, utilisée par des milliards d’individus partout dans le monde et étayant une grande partie du progrès d’aujourd’hui.

Pour ces raisons, Charles Babbage et Ada Lovelace sont nos quarante-neuvième héros du progrès.

—

Sur le web -Traduction par Joel Sagnes pour Contrepoints .

Les Héros du progrès, c’est aussi :